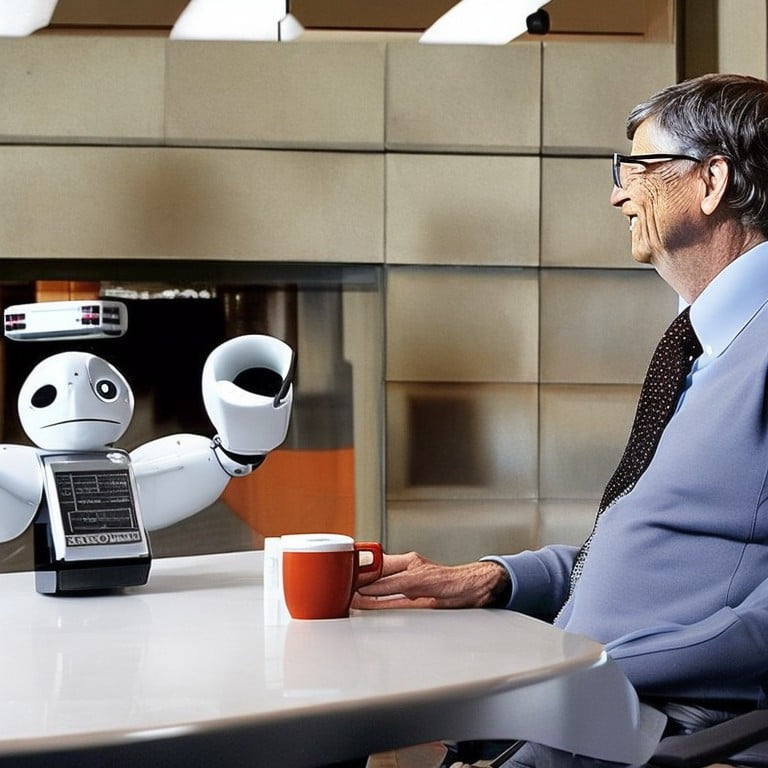

ביל גייטס, ממייסדי מיקרוסופט, מהמשקיעים של OpenAI, התייחס לכניסת הבינה המלאכותית לחיי היום-יום ושיבח אותה: "משנה את העולם".

בחודשים האחרונים, עם צאתם לאור של מודולי שיחה זמינים לקהל הרחב כגון ChatGPT, אנו עדים למהפיכה המתחוללת אשר תשפיע עמוקות על כל אחד מאיתנו בשנים הקרובות. מי שהתייחס לכך בבלוג שלו הוא לא אחר מאשר אחד ממייסדי מיקרוסופט והמנכ"ל הכל-יכול שלה, ביל גייטס. האדם העשיר בעולם לשעבר, ואחד המשפיעים ביותר במאה העשרים, פרסם פוסט ארוך בו הוא מתאר את הכניסה של הבינה המלאכותית לחיינו מנקודת מבטו.

"במהלך חיי הייתי עד לשתי טכנולוגיות שהדהימו אותי. האחת הייתה בשנות ה-80 כשהוצג בפני הממשק הגרפי הראשון במערכת ההפעלה שמאוחר יותר הפכה ל-Windows, וההפתעה השניה הייתה השנה. נפגשתי עם הצוות של OpenAI מאז שנת 2016 והתרשמתי מההתקדמות שלהם. באמצע 2022 התרגשתי מאותה ההתקדמות ונתתי להם אתגר: לאמן את הבינה המלאכותית לעבור בוחן מתקדם בביולוגיה. לאפשר לה לענות על כל השאלות שהיא לא אומנה באופן ספציפי עבורם. אם היא מצליחה, אז מדובר בפריצת דרך. חשבתי שהאתגר יותיר אותם עסוקים לעוד שנתיים או שלוש, אבל הם סיימו בתוך מספר חודשים".

עוד מספר גייטס על האתגר: "כשפגשתי אותם בספטמבר, ראיתי את ChatGPT עונה נכונה על 59 מתוך 60 השאלות במבחן המתקדם בביולוגיה, כולל 6 תשובות נהדרות לשאלות פתוחות בסיום אותו המבחן. הבאנו מומחה חיצוני לבדוק את התשובות, והוא נתן את הציון 5, הגבוה ביותר".

הסכנות הטמונות בבינה מלאכותית

כולנו בוודאי ראינו את אותם הסרטים, דוגמת מטריקס, בהם רובוטים משמידים את האנושות "החולה" ומשתלטים על העולם. על אף שמדובר במדע בדיוני, לכל אחד מאיתנו הסנריו הזה עבר בראש לפחות פעם אחת כאשר נגלה בפנינו העולם המופלא של ChatGPT. למרות זאת, אם יש אדם שידע להסביר באופן יותר ברור מה הסכנות האפשריות בבינה מלאכותית מבלי להישמע כה דרמטי, הוא ביל גייטס. "בוודאי שמעתם על הבעיות עם המודלי AI הנוכחיים, כמו למשל שהם לא מבינים בבירור את הבקשות של בני האדם, מה שמוביל לתוצאות מוזרות. אם תבקשו מהמודל להמציא סיפור בדיוני הוא יעשה זאת נהדר, אך אם תבקשו ממנו לתכנן עבורכם טיול ייתכן והוא יציין, לדוגמה, בתי מלון שלא קיימים. זה קורה מכיוון שהבינה המלאכותית לא מבינה את ההקשר בבקשתכם והאם היא צריכה להמציא מלונות או לבדוק איזה מהם אמיתיים ויש להם חדרים פנויים".

בנוגע לתשובות הלא נכונות בפעולות מתמטיות פשוטות, מסביר גייטס כי "הבינה המלאכותית מתמודדת עם נימוקים מופשטים. המפתחים עובדים על זה, ואני חושב שאנחנו נראה את התיקונים בתוך פחות משנתיים. כמו כן, יש את החשש שהבינה המלאכותית תצא משליטה. האם המכונה יכולה להחליט שבני האדם הם איום, להסיק שהאינטרסים שלה שונים משל בני האדם או פשוט להפסיק לדאוג לנו? אולי, אבל הבעיה הזאת היא לא יותר דחופה היום מאשר הייתה בעבר. הבינה המלאכותית הסופר-חכמה בעתיד תדע לקבוע לעצמה יעדים. מה הם יהיו? מה יקרה אם הם יתנגשו עם האינטרסים של בני האדם? האם אנחנו צריכים למנוע את המשך הפיתוח? השאלות האלה יהפכו לדחופות יותר עם הזמן".

לסיכום, גייטס מזכיר שכל הפיתוחים האחרונים בתחום הבינה המלאכותית מקרבים אותנו ל-AI סופר חכם, "strong AI", אך לדבריו בינה מלאכותית עדיין לא יכולה לשלוט בעולם הפיזי ולא יכולה לקבוע לעצמה יעדים.